玩转本地大模型Ollama官方唯一指定学习教程发布

Ollama官方唯一指定学习教程 🎉

11月6日, Handy-Ollama 开源教程被 Ollama 官方收录,成为目前唯一指定的官方学习教程:

https://github.com/ollama/ollama #tutorial

(需要进 读者交流群 可在文末留言)

开源初心:实现大模型技术普惠

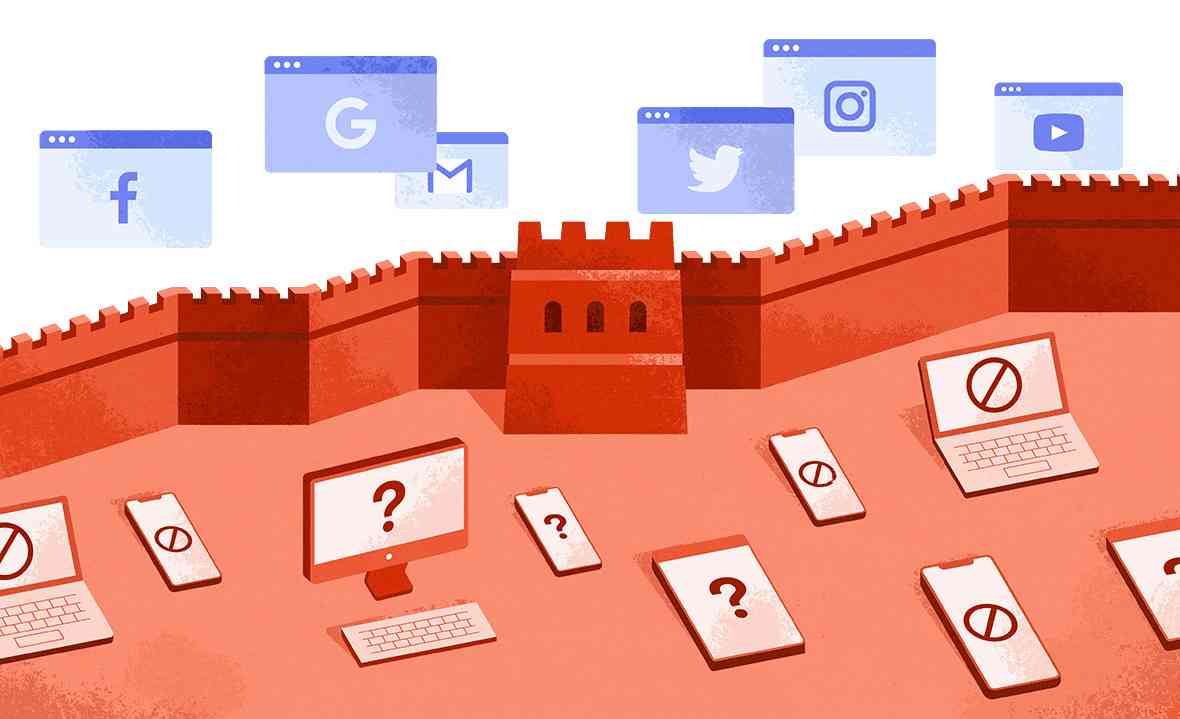

随着大模型技术浪潮的席卷,越来越多的开源模型不断涌现,但高昂的 GPU 资源门槛却将许多学习者与开发者拒之门外。 如何让大模型技术真正走进每个人的计算机,让更多人能 以低成本、低门槛的方式体验、使用甚至创造 AI 应用,成为当前亟需破解的难题。 Ollama 应运而生,作为一个轻量级的大模型本地部署工具,它仅凭 CPU 即可流畅运行各类主流模型,极大地降低了技术使用的门槛。

然而,当前关于 Ollama 的系统性、重实践的教程却极度匮乏。 为此,我们推出了《Handy-Ollama》这一开源教程,致力于通过系统化的内容与实战导向的指引,帮助每一位对 AI 感兴趣的人轻松在本地部署属于自己的大模型,进而探索应用开发的可能性,真正实现大模型技术的普惠与赋能,助力AI走入千行百业、千家万户。

项目简介

Handy-Ollama—— 动手学 Ollama 教程, 轻松上手实现大模型本地化部署,快速在本地管理以及运行大模型,让 CPU 也可以玩转 大模型推理部署。

在这个项目中你将获得:

🔍 深入学习 Ollama 以及它的安装和配置

🏗️ 掌握通过 Ollama 自定义导入模型

🛠️ 随时查阅 Ollama REST API 的使用方法

⚙️ 一步步实现 Ollama 在 LangChain 中的使用

🚀 实战 Ollama 可视化界面部署和应用案例

开源地址:

https://github.com/datawhalechina/ handy-ollama

面向受众

本项目适合 所有符合以下条件的学习者:

希望不受 GPU 资源限制,在本地运行大模型

希望在消费级硬件上进行大模型有效的推理

希望在本地部署大模型,开发大模型应用

希望在本地管理大模型,让本地模型安全可靠

特别感谢

特别感谢以下为教程做出贡献的同学。

开源贡献 , 点 赞 在看 ↓

共有 0 条评论